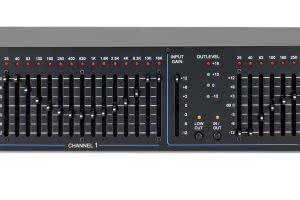

Znacznie łatwiej kojarzona jest natomiast tercjowa wersja korektora graficznego, która totalnie zdominowała rynek pod koniec lat 70. ubiegłego wieku. Wersja ta udostępniała 31 zakresów regulacyjnych, zorganizowanych w odstępach tercjowych, zaczynających się od częstotliwości środkowej 31 Hz. Trzeba tu jednak wyraźnie zaznaczyć, że w początkowym okresie nie obowiązywała ścisła standaryzacja, co do profilu wykorzystywanych filtrów, i dlatego jeden producent mógł stosować w urządzeniach filtry tercjowe, a inny producent filtry oktawowe. Niezależnie od tego, niewątpliwym urokiem korektorów graficznych było wizualne „odwzorowanie” na przedniej płycie urządzenia wprowadzonych przez realizatora ustawień – stąd zresztą wzięła się nazwa tych urządzeń.

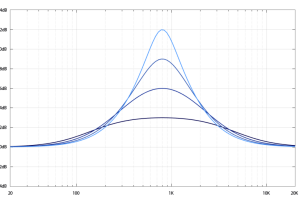

Niestety, w rzeczywistości wspomniane odwzorowanie ustawień, reprezentowane przez pozycję suwaków na płycie przedniej, było raczej umowne. Najbliższa prawdy wersja odwzorowania ustawień zachodziła wówczas, gdy wszystkie suwaki znajdowały się dokładnie w położeniu „0”. W sytuacji kiedy suwaki zostały przesunięte w inne położenia, podobieństwo oddalało się z racji tego, że odpowiadające im filtry, wpływały wzajemnie na obszary działania sąsiednich filtrów, a ich interakcja drastycznie wpływała na rozbieżności pomiędzy „grafiką” widoczną na przedniej płycie korektora, a faktyczną charakterystyką wprowadzonych zmian. Szczerze mówiąc, grafika widoczna na płycie przedniej korektora nigdy nie była wiernym odwzorowaniem zmian, a w przypadku niektórych filtrów – zwłaszcza tych, o szerokim obszarze działania (niskiej wartości współczynnika dobroci Q) – była ona wysoce nieprecyzyjna.

Opisana tu sytuacja dotycząca korektorów graficznych, powodowała często sporo zamieszania, a wszystko dlatego, że niektórzy użytkownicy próbowali w pierwszej kolejności ustawić „obrazek” na płycie przedniej, oczekując później określonego wyniku swojego działania. Jednak efekt – weryfikowany już osłuchowo – bywał niekiedy bardzo daleki od spełnienia tych oczekiwać. Doświadczeni realizatorzy szybko nauczyli się nie ufać bezkrytycznie „obrazkowi” powstającemu na płycie przedniej wiedząc, że w danym momencie korektor nie działa dokładnie tak, jak sugeruje to widziany układ suwaków. Rzecz w tym, że trudno było jednoznacznie stwierdzić jak działa dany korektor w rzeczywistości przy widocznym układzie suwaków. Dlatego rozbieżności pomiędzy działaniem korektorów graficznych a charakterystyką utworzoną przez układ suwaków na płycie przedniej bywały przyczyną formułowania różnych, błędnych wniosków.

Korektory graficzne o wąskich filtrach (wysokiej wartości współczynnika Q), tworzyły zwykle mocno „połamaną” (czytaj – nieprzyjazną dla oka) grafikę płyty przedniej. Była ona pofalowana tym mocniej, im głębsze były cięcia (lub podbicia) wprowadzane przy użyciu poszczególnych filtrów. Jednak ten urągający poczuciu estetyki „połamaniec” widniejący na płycie przedniej, z akustycznego punktu widzenia (a o to przecież chodziło) miał swoją niewątpliwą zaletę. Częstotliwość środkowa była w tym przypadku tłumiona mocniej, niż obszary pomiędzy sąsiednimi filtrami. Filtry o szerokim zakresie reagowania nie tworzyły tak „odrażającego obrazka”, za to mocno oddziaływały na siebie wzajemnie, co powodowało duże rozbieżności pomiędzy widocznymi na płycie korektora i faktycznymi zmianami w charakterystyce sygnału. Jedynym wyjątkiem – korektorem cieszącym się do dziś ogromnym szacunkiem wielu, zwłaszcza starej daty realizatorów – był Klark Teknik DN360. Korektor ten wyposażony został w filtry o proporcjonalnej charakterystyce działania. Oznacza to, że im większy był poziom podcięcia (lub podbicia) danej częstotliwości środkowej, tym bardziej zawężał się obszar działania filtra, a więc, zmniejszał się też obszar jego interakcji z filtrami sąsiednimi.

Warto w tym miejscu przypomnieć, że przez korektor przechodził zawsze cały sygnał akustyczny. Z uwagi na ten fakt, wszelkie zniekształcenia, tłumienie sygnału, szumy własne, a także inne mankamenty wynikające z niskiej jakości komponentów oraz konstrukcji urządzenia, miały wyraźnie odczuwalny wpływ na jakość działania całego systemu nagłośnieniowego. O skali i rodzaju ewentualnych zjawisk niepożądanych decydował w znacznym stopniu typ i jakość komponentów elektronicznych zastosowanych przez producenta filtrów, a więc wybór częstotliwości środkowych, dla których możliwe było wprowadzanie zmian, tłumienie sygnału, dobroć, szum własny, odporność na zakłócenia zewnętrzne itd. Warto również powiedzieć, że niedokładność „odwzorowania” powstającego na płycie przedniej podczas procesu korekcji nie była zdecydowanie żadnym problemem – pod jednym aczkolwiek ważnym warunkiem, gdy proces korekcji prowadzony był „na ucho”, bez zbędnego zagłębiania się w estetykę jego wizualizacji. Niestety uwolnienie się od tego rodzaju nawyku, stało się rzeczą najtrudniejszą do pokonania. Podobnie jak miało to często (ma, i będzie miało w przyszłości) miejsce w przypadku korzystania z wielu innych urządzeń czy operacji, z czasem zaczął tworzyć się pewien rodzaj „kultu” posługiwania się korektorem graficznym. Jak przysłowiowe grzyby po deszczu, lawinowo pojawiały się kolejne niedorzeczne teorie dotyczące „wizualnych zasad” rządzących położeniem suwaków na płycie. Jedna z nich – chyba najbardziej rozpowszechniona – nakazywała, by po podcięciu danej częstotliwości środkowej, delikatnie podciąć również częstotliwości sąsiednie. Jeśli więc przykładowo ruszyliśmy w dół suwak dla częstotliwości 500 Hz, to w myśl wspomnianej zasady, należało delikatne przesunąć w dół również suwaki filtrów 315, 400, a także 639 i 800 Hz, w celu wizualnego uzyskania łagodnej krzywej korekcji na płycie przedniej!!!

Pomijam w tym momencie fakt, że takie wyrażenia, jak „delikatne”, „niewielkie” czy „nieznaczne”, to określenia doprawdy „precyzyjne”, którym trudno jest przyporządkować jakąkolwiek wymierną wartość. Zwracam natomiast uwagę na inny fakt, a mianowicie to, że pomysłodawcy wspomnianej „zasady”, jakoś nie przyszło do głowy, że przesunięcie w dół jednego tylko przykładowego suwaka 500 Hz, zwykle powodowało głębszy i szerszy obszar podcięcia tejże częstotliwości – zależnie od typu oraz sposobu reagowania filtrów zastosowanych w danym urządzeniu. Inna z podobnych gatunkowo „zasad” ostrzegała, że podcięcie danej częstotliwości o więcej niż 6 dB powoduje poważne problemy fazowe. Niestety – również i w tym przypadku – występujące w jakimś enigmatycznym, bliżej niesprecyzowanym przez jej autora wymiarze. Nikt oczywiście nie wiedział o co dokładnie chodzi, ale na wszelki wypadek, spora część realizatorów potraktowała problem z należną mu powagą i... przyjęła tę „zasadę” jak własną! Ktoś powiedział, że cięcie głębsze niż 6 dB powoduje problemy z fazą, ktoś inny słyszał coś o przesunięciu fazowym filtrów, więc szybko to sobie skojarzył i jak to często bywa w podobnych sytuacjach, dodał również „co nieco” od siebie. W taki oto sposób, krążąca z ust do ust pseudo-teoria (by nie użyć stwierdzenia plotka), urosła do rangi prawdy objawionej. Nikt nie zadawał sobie trudu, by dowiedzieć się czegokolwiek więcej, a przede wszystkim, by dowiedzieć się, czy w ogóle jakiekolwiek problem związany jest z działaniem, o którym była mowa. Uznano, że tak po prostu jest i wystrzegano się przekroczenia tej granicy jak zarazy!

Nie można oczywiście powiedzieć, że podczas strojenia systemu absolutnie nikomu nie przytrafiły się problemy z fazą. Nie można też jednoznacznie stwierdzić, czy ewentualne problemy były w rzeczywistości spowodowane przekroczeniem granicy „magicznych 6 dB”, czy tylko błędną interpretacją wypadkowej kilku innych czynności, wykonanych podczas całego procesu korekcji. Można natomiast powiedzieć, że precyzyjne analizatory pokazujące odpowiedź fazową, które pojawiły się w użyciu nieco później, nie potwierdziły słuszności wspomnianej „zasady 6 dB”, która w międzyczasie zdążyła zyskać sobie rangę aksjomatu. Problemy fazowe, które identyfikowały precyzyjne analizatory, były głównie efektem towarzyszącym anomaliom amplitudowym, wynikającym najczęściej z nadmiernego pofalowania krzywej korekcji, czyli mówiąc prościej, korzystania ze zbyt dużej liczby, a do tego błędnie wytypowanych filtrów.

Problemy z korektorami graficznymi

Tak oto dochodzimy do bardzo istotnej części rozważań dotyczącej korektorów graficznych. Głównym mankamentem tych urządzeń były (i są) stałe częstotliwości środkowe, wyznaczone przez producenta, a także ustalona szerokość reagowania filtrów. Z uwagi na ten fakt, korektory graficzne nigdy nie mogłyby stać się skutecznym narzędziem w procesie optymalizacji systemów nagłośnieniowych. Szereg problemów, które w tym procesie próbuje się rozwiązać, nie zawsze mieści się w stałej szerokości i nie zawsze pokrywa się dokładnie z częstotliwością środkową ISO. Optymalizacja jest procesem bardzo złożonym, wykraczającym daleko poza możliwości standardowego korektora graficznego. Jeżeli precyzyjny analizator identyfikuje problem pojawiający się przy częstotliwości 900 Hz, to możliwość rozwiązania go za pomocą korektora graficznego, wiąże się ze sporym ograniczeniem. Zbliżone do tego obszaru filtry o stałych częstotliwościach i ustalonej szerokości reagowania, przewidziane są najczęściej dla częstotliwości 800 Hz i 1 kHz. Oczywiście można skorzystać z obydwu tych filtrów jednocześnie, ale z uwagi na sposób reagowania, ewentualne rozwiązanie jednego problemu, będzie z dużym prawdopodobieństwem skutkowało pojawieniem się kolejnego problemu lub kilku innych.

O wiele bardziej efektywnym narzędziem był w takim przypadku korektor parametryczny, który wyposażony został w zestaw niezależnych filtrów, o możliwej do przestrojenia częstotliwości środkowej, szerokości reagowania oraz poziomie tłumienia lub wzmocnienia. Każdy identyfikowany przez analizator problem, mógł być teraz rozwiązany za pomocą korektora parametrycznego – jednym „chirurgicznym” cięciem, bez szkodzenia obszarom nie wymagającym żadnej ingerencji. Korektor parametryczny miał się stać naturalnym następcą używanego wcześniej korektora graficznego, a pojawienie się w użyciu precyzyjnych analizatorów o wysokiej rozdzielczości, miało być przysłowiowym „gwoździem do trumny”, całkowicie przesądzającym o losie popularnych „grafików”. Dzięki nowoczesnym analizatorom można było obserwować odpowiedź fazową, co przyczyniło się do obalenia wielu „poufnych” teorii na ten temat, a także monitorować zmiany amplitudowe, będące wypadkową działania wykorzystanych w procesie korekcji filtrów. Nowoczesne analizatory potwierdziły, że korektor graficzny nigdy nie spełni wymagań stawianych w procesie optymalizacji współczesnego systemu. Mimo to, przepowiadana rezygnacja z używania popularnych wśród realizatorów korektorów graficznych, odwlekała się o kolejne lata, a w rzeczywistości, nigdy nie zaniechano ich stosowania. Co prawda nie są one dziś wykorzystywane w procesie optymalizacji systemów nagłośnieniowych, ale wielu realizatorów nadal chętnie używa ich do kreowania ogólnego brzmienia, a także jako niezastąpione narzędzie do eliminacji sprzężeń w systemach odsłuchowych na scenie, bazujących na monitorach podłogowych.

Jakie jest rozwiązanie problemów z korektorami graficznymi?

Co zaś tyczy się korektorów parametrycznych, to nie pojawiły się one w użyciu z dnia na dzień! Nie były też żadnym technologicznym objawieniem, ponieważ metody korzystania z filtrów w procesie korekcji dźwięku, stosowane były na długo przed pojawieniem się na rynku korektorów parametrycznych – jako samodzielnych urządzeń. Jednak w przypadku koncertowych systemów nagłośnieniowych, do czasu pojawienia się w użyciu precyzyjnych analizatorów o wysokiej rozdzielczości, popularność korektorów parametrycznych była niewielka – można powiedzieć, że praktycznie znikoma. Na taki stan rzeczy składało się kilka powodów.

Po pierwsze – żeby dowiedzieć się, jakie zmiany wprowadza w danym momencie korektor parametryczny, należało sczytać ustawienia parametrów każdego z (zwykle 4 - 6) filtrów. Po drugie – sczytane ustawienia należało przetworzyć (w głowie), zaprzęgając do pracy własną wyobraźnię. Taki proces wymagał pewnego doświadczenia, więc dla wielu nie posiadających go osób, był on poważnym problemem. Co gorsza wszystkie parametry decydujące o reagowaniu każdego z filtrów mogły być przestrajane dowolnie, a to oznacza, że filtry mogły być porządkowane kaskadowo (uzupełniać się), ale też obszary ich działania mogły się pokrywać w dozwolonym przez użytkownika zakresie, a analogowe urządzenia, nie wizualizowały wypadkowej działania zespołu użytych filtrów. Oprócz widniejącego na przedniej płycie urządzenia opisu funkcji i wyskalowania elementów regulacyjnych, resztę należało samodzielnie „wygenerować” w głowie.

Wymagało to spojrzenia na pozycje elementów regulacyjnych każdego z filtrów, powiązania wskazywanej wielkości ze sposobem reagowania i „wyczarowanie” z tych informacji aktualnej charakterystyki. Oprócz fotograficznej pamięci, no i przede wszystkim zdolności kojarzenia wskazywanych przez regulatory wielkości ze sposobem reagowania filtra (przykładowo GAIN -3, FREQ 500 x 10, B/W 0.8), należało później jeszcze poskładać wszystko w całość, by uzyskać wypadkową charakterystykę działania wszystkich użytych filtrów. Wielu starych realizatorów, przyzwyczajonych wcześniej do korzystania z korektorów graficznych, proces ten mocno dezorientował powodując, że czuli się bardzo niepewnie i pomimo niewątpliwych zalet urządzenia, na korektor parametryczny spora ich część reagowała alergicznie. Współczesne korektory parametryczne, stosowane w konsoletach cyfrowych, procesorach sygnału lub interfejsach (GUI) różnego rodzaju oprogramowania, wyposażone zostały w okna pokazujące interakcję współpracujących filtrów w odniesieniu do wprowadzanych przez użytkownika zmian parametrów. Dzięki temu działanie korektora parametrycznego nie jest już czymś tajemniczym, a wyobraźnia realizatorów została oswobodzona z przymusu błyskawicznego tworzenia wizualizacji dokonywanych zmian.

Sporym mankamentem niektórych wczesnych modeli, komercyjnie dostępnych korektorów parametrycznych były używane w nich filtry. Marketingowy szum wywołany nagle wokół możliwości tych urządzeń sprowokował błyskawiczną reakcję producentów. Niestety w początkowym okresie, część dostępnych na rynku korektorów parametrycznych, wyposażona była w filtry, których topologia nie zawsze kwalifikowała te urządzenia jako odpowiednie narzędzie do optymalizacji systemu. Filtry prezentowały asymetryczny sposób reagowania, charakteryzując się różnym zachowaniem po stronie tłumienia i wzmocnienia. Pomimo regulacji szerokości działania, taki filtr po stronie tłumienia zachowywał się jak filtr wycinający (typu notch) i nie zawsze dobrze radził sobie z przyrostami o wysokiej amplitudzie, które miał za zadanie wyrównać. Natomiast po stronie wzmocnienia, przy minimalnym nawet ustawieniu szerokości, często i tak reagował w zbyt szerokim przedziale. Urządzenia wyposażone w filtry o tego rodzaju topologii (wąski zakres tłumienia i zbyt szeroki zakres wzmocnienia) niekiedy w większym stopniu same imitowały efekty kłopotliwej filtracji grzebieniowej, niż kompensowały wynikające z występowania tego zjawiska problemy. Jak wspomniałem wcześniej, analogowe korektory parametryczne spotkały się raczej ze sceptycznym przyjęciem niektórych realizatorów – głównie z powodu braku graficznego interfejsu użytkownika. Niechętne nastawienie zmieniły dopiero urządzenia cyfrowe, a wprowadzenie do użycia rozbudowanych procesorów sygnału, integrujących funkcje wielu wcześniej używanych pojedynczo analogowych urządzeń, ułatwiło kontrolowanie amplitudy i zgodności fazowej sygnału, redukując przy okazji ilość używanego wcześniej okablowania oraz konieczność częstych zmian konfiguracji połączeń, ale o tym, kilka zdań za chwilę.

Nowoczesne analizatory o wysokiej rozdzielczości wykorzystujące funkcję transferu, umożliwiły porównywanie różnic pomiędzy dwoma dowolnie wybranymi punktami w torze sygnału – przykładowo na wyjściu EQ w odniesieniu do wejścia, dając precyzyjny obraz zmian powodowanych przez dane urządzenie.

Na scenę wkracza cyfra

Erę urządzeń cyfrowych zainaugurowały cyfrowe procesory efektów i linie opóźniające, które zastąpiły poprzednią generację analogowych urządzeń tego typu, prezentujących kiepską dynamikę i dostępne zakresy czasowe. Jednak pierwsza generacja urządzeń cyfrowych tego typu – choć prezentowała większe możliwości od swoich analogowych poprzedników – pod względem jakości pozostawiała również wiele do życzenia. Jeśli porównać niektóre linie opóźniające pierwszej generacji z dzisiejszymi DSP, to urządzenia te z uwagi na jakość ówczesnych konwerterów A/D, prezentowały spory poziom szumu, a także gorszą rozdzielczość i dynamikę. Powodowało to, że były one używane raczej oszczędnie – czyli wyłącznie w sytuacjach, w których było to absolutnie niezbędne. Systemy nagłośnieniowe w tamtym okresie wyposażone były więc w cyfrowe linie opóźniające, cyfrowe efekty, analogowe korektory i analogowe matryce sygnału, będące często modułem konsolety głównej. Wszystkie wymienione tu elementy oferowały niewielką liczbę wejść i wyjść, więc w przypadku rozbudowanego systemu nagłośnieniowego, wymyślenie metody efektywnego zarządzania nim wymagało niekiedy dużej kreatywności. Dlatego kiedy tylko technologia cyfrowa okrzepła i zaczęła coraz śmielej zawłaszczać rynek sprzętu pro audio, narodziła się koncepcja połączenia wielu używanych wcześniej urządzeń w jedną całość. Pomysł ten miał oczywiście swoją wadę, ale poza nią prezentowały już tylko same zalety.

Wadą była konieczność „zaprzyjaźnienia się” z enkoderami – gałkami bez żadnej skali, obracającymi się bez żadnego ograniczenia w prawo lub w lewo, a do tego konieczność korzystania z listy menu, wyboru parametrów i śledzenia zmian ich wielkości na wyświetlaczu. Dla starszej generacji realizatorów było to kolejne deprymujące wyzwanie – zwłaszcza, że niektóre wczesne modele procesorów cyfrowych miały wyświetlacze mało przyjazne dla oka, a w sytuacjach szczególnych (np. w intensywnym świetle słonecznym) prezentowane tam informacje były praktycznie niemożliwe do odczytania. Oprócz wymienionego powyżej mankamentu, pozostawały już tylko same zalety, jak: eliminacja sporej ilości niezbędnego dotychczas okablowania, pól krosowniczych, częstego modyfikowania połączeń, ale przede wszystkim, konieczności przestrzegania pewnych zasad dotyczących prowadzenia sygnałów audio i zasilania poszczególnych urządzeń, by ustrzec się kłopotliwego zapętlenia mas.

Rozwój procesorów DSP podążył w dwóch głównych kierunkach – procesorów o otwartej topologii, umożliwiających wstawianie pomiędzy danym wejściem i wyjściem wirtualnych urządzeń pobranych z pokładowej biblioteki, oraz procesorów o zamkniętej topologii, pozwalających na kształtowanie toru sygnału w pewien z góry określony przez producenta sposób. Cyfrowe filtry, w które wyposażone zostały nowoczesne procesory „naśladowały” sposób reagowania filtrów dobrze znanych z okresu świetności analogów. Jednak z czasem okazało się, że te ostatnie nie zawsze spełniają wszystkie potrzeby wynikające z procesu optymalizacji systemu. Z uwagi na ten fakt, zainteresowanie konstruktorów zwróciło się w stronę pewnej „egzotyki” w postaci filtrów FIR czy all-pass. Mimo to, w wielu nowoczesnych procesorach sygnału wciąż znajdujemy dostępną opcję korektora graficznego, który – pomimo omówionych tu mankamentów – przez kilka dekad był prawdziwym „wołem roboczym” wykorzystywanym przez kolejne pokolenia realizatorów. Tak pokrótce wygląda historia i współczesność korektorów graficznych, a także parametrycznych. W numerze powakacyjnym przyjrzymy się „drugiej stronie”, czyli analizatorom sygnałów.