Rola sztucznej inteligencji, zarówno w rozumieniu, jak i procesie tworzenia muzyki, znacznie wzrosła od lat pięćdziesiątych XX wieku. Od podstawowych algorytmów, po wieloaspektowy przemysł z inteligentnymi systemami muzycznymi, postępujący rozwój sztucznej inteligencji muzycznej pokazuje techniczną ekspansję tej metodologii.

Wczesne etapy rozwoju sztucznej inteligencji w muzyce (lata 50. - 70.)

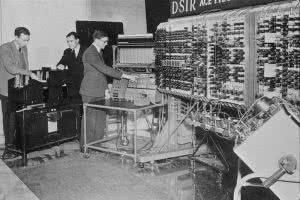

Pierwsze próby z muzyką generowaną komputerowo pojawiły się w latach pięćdziesiątych XX wieku, ze szczególnym naciskiem na proces tworzenia algorytmicznego. Pojawienie się tego rodzaju muzyki, co zawdzięczamy pionierom takim jak Alan Turing, posługującemu się komputerem Manchester Mark II, otworzyło wiele możliwości w zakresie badań nad inteligencją muzyczną, w których wykorzystywano systemy obliczeniowe potrafiące rozpoznawać, tworzyć i analizować utwory muzyczne.

Wczesne eksperymenty koncentrowały się w szczególności na komponowaniu algorytmicznym (komputer tworzy muzykę w oparciu o sformalizowane zbiory reguł). W 1957 roku powstał pierwszy utwór skomponowany wyłącznie przez sztuczną inteligencję — Illiac Suite na kwartet smyczkowy.

Wykorzystując modele matematyczne i algorytmy, Lejaren Hiller (amerykański kompozytor) i Leonard Isaacson (amerykański kompozytor i matematyk) stworzyli Illiac Suite, pierwszy utwór skomponowany w całości przez komputer. Wykorzystali do tego celu algorytm Monte Carlo, który generował losowe liczby, odpowiadające określonym cechom muzycznym, takim jak wysokość tonu czy rytm. Korzystając z zestawu reguł ograniczających, owe losowe cechy zostały okrojone jedynie do tych, które można było uznać za „poprawne” z punktu widzenia zasad tradycyjnej teorii muzyki, prawdopodobieństwa statystycznego (łańcuchy Markowa) i wyobraźni kompozytorów.

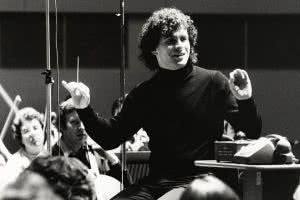

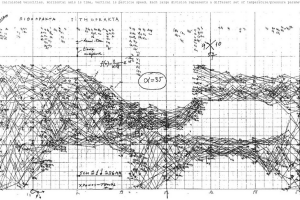

Innym innowatorem w tej dziedzinie był Iannis Xenakis, kompozytor i inżynier, który we własnej twórczości wykorzystywał prawdopodobieństwa stochastyczne. Proces stochastyczny to mechanizm z losowym rozkładem prawdopodobieństwa, którego nie można przewidzieć, ale da się analizować metodami statystycznymi. Już na początku lat 60. Xenakis wykorzystał komputer i język FORTRAN do zaprogramowania zbioru funkcji prawdopodobieństwa, określających ogólną strukturę i szereg właściwości kompozycji (takich jak wysokość tonu i dynamika).

Xenakis modelował swoją muzykę w taki sposób, jakby chodziło o eksperyment naukowy. Każdy instrument był niejako cząsteczką, podlegającą stochastycznemu, losowemu procesowi, który decydował o jej zachowaniu (wysokość dźwięków i dynamika poszczególnych nut).

Jego prace stanowiły punkt wyjścia dla wielu nowych metod tworzenia muzyki, ale posłużyły również jako wczesny przykład zastosowania sztucznej inteligencji, działającej jako narzędzie analityczne, a nie tylko kompozytorskie. Sposób, w jaki Xenakis tworzył swoje melodie i orkiestrację na różne instrumenty, opierał się na przestrzeniach dźwiękowych modelowanych przez proces stochastyczny.

Ta dwoistość sztucznej inteligencji, jako autonomicznego twórcy, a jednocześnie narzędzia wspomagającego, utrzymuje się do dziś. Wśród systemów inteligentnych wyróżnić możemy takie, które specjalizują się w generowaniu nowych utworów, jak np. Illiac Suite, oraz stochastyczne i analityczne, jakimi posługiwał się Xenakis.

Okres przejściowy rozwoju sztucznej inteligencji w muzyce — modelowanie generatywne (lata 80. - 90. XX wieku)

W dziesięcioleciach poprzedzających współczesną erę muzyki nacisk przesunął się z prostego, algorytmicznego komponowania muzyki na modelowanie generatywne. Otto Laske, wybitny badacz w dziedzinie sonologii, opisuje tę zmianę jako różnica pomiędzy muzycznym robotem a inteligencją muzyczną.

Działanie robota muzycznego jest bardziej zbliżone do wczesnych eksperymentów z lat 50. i 60. — potrafi rozpoznawać wzorce, zna gramatykę muzyczną i ma ogólną umiejętność rozwiązywania problemów, ale swoje cele osiąga dość bezpośrednimi i topornymi metodami. Z drugiej strony inteligencja muzyczna zastępuje tę robotyczną, brutalną metodologię systemem opartym na wiedzy i świadomości sposobów funkcjonowania rozmaitych elementów muzycznych.

Ów trend w kierunku rozwoju systemów AI budujących własne, samowystarczalne pojmowanie znaczenia poszczególnych elementów muzyki stał się podstawą ewolucji inteligencji muzycznej do wyższego poziomu, jaki obserwujemy dzisiaj.

David Cope (kompozytor i profesor muzyki), prowadzący w latach 80. własne eksperymenty z inteligencją muzyczną (EMI), był zagorzałym zwolennikiem opinii, że zakres kompozycji komputerowej może obejmować głębsze zrozumienie muzyki za pomocą 3 podstawowych metod:

(1) dekonstrukcja (analiza i podział na części)

(2) sygnatura (wspólne cechy — zachowanie elementów określających styl muzyczny)

(3) kompatybilność (rekombinacja — ponowne łączenie elementów muzycznych w nowe utwory)

Jego prace obracały się wokół idei rekombinacji, w ramach której elementy z poprzednich prac są łączone i modyfikowane, w rezultacie czego powstają nowe utwory muzyczne. Niektórzy spośród największych kompozytorów wszech czasów również stosowali rekombinację (świadomie lub nie), przekształcając istniejące pomysły/style w nowe dzieła. David Cope starał się odtworzyć tę metodykę w ramach programu EMI, z wykorzystaniem komputerów i ich zdolności obliczeniowych.

Praca Cope'a stała się podstawą dla wielu obecnie stosowanych modeli sztucznej inteligencji. W pierwszym etapie muzyka i jej atrybuty są kodowane w bazach danych, a następnie zbiór rekombinowanych segmentów jest wyodrębniany przy użyciu zadanych identyfikatorów i systemów dopasowywania wzorców. W kolejnych krokach segmenty muzyczne są kategoryzowane i zestawiane w logicznym, muzycznym porządku, przy użyciu rozszerzonych sieci połączeń, aż do wyprodukowania gotowego dzieła. Taka koncepcja „regeneratywnej” konstrukcji muzyki przywodzi na myśl sposób działania sieci neuronowych, które współcześnie samodzielnie komponują utwory muzyczne.

Kolejne osiągnięcia owego okresu coraz dalej przesuwały granice kreatywności obliczeniowej. Na przykład Robert Rowe stworzył system, który potrafił wywnioskować metrum, tempo i długość nut z „żywego” wykonania danego utworu. W 1995 roku firma Imagination Engines wytrenowała sieć neuronową, wykorzystując zbiór popularnych melodii i stosując uczenie przez wzmacnianie, w efekcie czego wygenerowała ona ponad 10.000 nowych motywów muzycznych. Proces uczenia przez wzmacnianie polega na szkoleniu sieci neuronowej pod kątem uzyskania określonego rezultatu poprzez nagradzanie/karanie modelu, w zależności od trafności decyzji, jakie podejmuje.

Okres bieżący rozwoju sztucznej inteligencji w muzyce (od roku 2000 do chwili obecnej)

Na obecnym etapie rozwoju sztucznej inteligencji w dziedzinie muzyki korzenie modelowania generatywnego i kompozycji algorytmicznej dynamicznie rozprzestrzeniły się na badania wyższego poziomu, a nawet na cały przemysł muzyczny. Dzięki zastosowaniu bardziej eksperymentalnych algorytmów i głębszych sieci neuronowych, rola sztucznej inteligencji muzycznej w procesie twórczym znacznie wzrosła

Inteligentna kompozycja z Iamusem

Powstały w 2010 roku Melomics Iamus był pierwszym komputerem, który potrafi komponować muzykę klasyczną we własnym stylu. Iamus to klaster komputerowy, wykorzystujący algorytmy ewolucyjne do komponowania motywów muzycznych, wykazujący przy tym pewne odstępstwa względem generatywnego modelu Cope'a, który opierał się na dziełach już istniejących.

Podobnie jak w przypadku procesu doboru naturalnego, losowo wygenerowany utwór muzyczny ulega mutacji (zmienione brzmienie, dynamika itp.). Ewolucja ta pozwala losowemu fragmentowi wejściowemu rozwinąć się w przeciągu kilku minut w setki kompozycji, spełniających kryteria pełnoprawnej muzyki.

Analiza muzyczna w projekcie Magenta

Magenta to projekt rozpoczęty przez Google Brain, wykorzystujący uczenie maszynowe jako narzędzie usprawniające proces twórczy. W jego ramach powstał szereg aplikacji demonstrujących możliwości inteligencji muzycznej, takie jak transkrypcja dźwięków za pomocą sieci neuronowych czy łączenie partytur muzycznych z tak zwanymi utajonymi modelami przestrzeni. Głębię analizy muzycznej, jakiej dokonuje Magenta, możemy poznać na przykładzie eksperymentów z MusicVAE.

MusicVAE to model uczenia maszynowego, pozwalający komponować utwory muzyczne poprzez łączenie partytur. Dzieje się to dzięki zastosowaniu ukrytego modelu przestrzennego, w którym wielowymiarowy zbiór danych przekładany jest na bardziej zrozumiały język matematyczny. Dokonuje tego autoenkoder, który wykorzystuje zestaw melodii i kompresuje (koduje) każdy ich element do postaci wektorowej, a następnie przekształca ów wektor w samą melodię (dekodowanie).

Po nauczeniu się, jak kompresować i dekompresować zbiory danych wejściowych, autoenkoder uczy się cech wspólnych dla całego zbioru. Na tej zasadzie opiera się MusicVAE, ale wprowadza do całego procesu struktury hierarchiczne, tworzące strukturę sumaryczną.

Pracując w oparciu o tę strukturę, MusicVAE jest w stanie konstruować aplikacje do tworzenia interpolacji, schematów perkusyjnych i całkowicie nowych pętli melodycznych, na bazie muzycznych danych wejściowych.

Synteza dźwięku przy użyciu NSynth

Podczas gdy większość wczesnych badań koncentrowała się na procesie komponowania, obecnie prowadzone eksperymenty rozszerzono o uczenie maszynowe w zakresie syntezy dźwięku. Magenta NSynth (Neural Synthesizer) wykorzystuje sieci neuronowe do tworzenia brzmień na poziomie pojedynczych sampli, a nie przy użyciu oscylatorów/tablic falowych, jak tradycyjne syntezatory. Takie podejście pozwala na większą artystyczną kontrolę nad finalną barwą (specyficznym charakterem dźwięku), co w istotny sposób wspomaga proces twórczy.

NSynth używa tak zwanego autoenkodera w stylu Wave-Net, pracującego na zbiorze danych zawierającym 300.000 próbek muzycznych, pozyskanych z około 1.000 instrumentów. Ten unikalny zestaw danych pozwala na faktoryzację dźwięku muzycznego na poszczególne nuty i inne cechy na podstawie zależności opartych na twierdzeniu o prawdopodobieństwie całkowitym.

Zadaniem autoenkodera jest modelowanie barwy dźwięku - P(audio | nuta) w powyższym równaniu - w przestrzeni utajonej. NSynth wykorzystuje koder czasowy z algorytmami matematycznymi, określanymi jako sploty. Po przejściu przez 30 warstw tych splotów obie nuty wejściowe są kompresowane do 16 wymiarów odpowiadających 16 cechom dźwięku w domenie czasu. Następnie skompresowane dane są poddawane próbkowaniu w górę i interpolowane, w rezultacie czego powstają nowe osadzenia (matematyczne reprezentacje dźwięku). Ostatni krok polega na syntezie szeregu nowych dźwięków, noszących cechy obu brzmień wejściowych, poprzez dekodowanie owych osadzeń.

Modelowanie generatywne z Jukebox

Większość eksperymentów w zakresie autonomicznego komponowania muzyki ma tendencję do jej generowania w sposób symboliczny, zwykle za pomocą edytora pianolowego lub MIDI, które służą jako język opisujący dźwięki/sekwencje. Jukebox OpenAI przenosi modelowanie generatywne na wyższy poziom, bezpośrednio modelując muzykę i ludzki głos jako surowy dźwięk. Dzięki takiemu podejściu Jukebox może generować melodie, kompozycje, barwy, a nawet prosty śpiew w różnych gatunkach i stylach. Aby poradzić sobie z głębią informacji semantycznych surowego brzmienia, używa wyspecjalizowanych koderów i sieci neuronowych.

Jukebox kompresuje dźwięk do utajonej przestrzeni za pomocą koderów VQ-VAE. Łańcuch przetwarzania otwiera proces kodowania dźwięku przy użyciu splotowych sieci neuronowych, po czym następuje wyszukiwanie wzorców w jego wynikach. Splotowa sieć neuronowa (CNN) to algorytm, który może pobierać obraz wejściowy i przedstawiać jego unikalne cechy w sposób matematyczny, za pomocą wielowymiarowych macierzy. CNN może być użyty również w przypadku dźwięku i wykorzystany do stworzenia wizualnej reprezentacji próbki audio (jak np. spektrogram).

Aby przeciwdziałać utracie danych muzycznych w procesie kodowania, Jukebox wykorzystuje kombinację funkcji strat i upsamplerów, co pozwala na zachowanie informacji. Wzorce te są następnie dekodowane do postaci nowego dźwięku przy użyciu większej liczby CNN.

Jednak Jukebox różni się od innych modeli charakterem VQ-VAE, ponieważ zasadniczo jest to autoenkoder z cechą określaną jako „wąskie gardło dyskretyzacji”, co oznacza, że zachowuje różne ilości informacji muzycznych na trzech niezależnych poziomach rekonstrukcji (każdy poziom koduje inną ilość informacji). To użycie oddzielnych koderów zamiast systemu hierarchicznego pozwala modelowi lepiej obsługiwać utajoną przestrzeń surowego dźwięku, ponieważ dźwięk można zrekonstruować z dowolnej spośród tych trzech warstw.

Porównanie rekonstrukcji widmowej z różnych VQ-VAE, z czasem na osi x i częstotliwością na osi y. Trzy kolumny to różne poziomy rekonstrukcji. Górna warstwa to rzeczywisty dźwięk źródłowy. Drugi wiersz prezentuje efekty działania oddzielnych autoenkoderów w Jukebox. W trzecim wierszu prezentowane są wyniki uzyskane bez funkcji strat widmowych. W czwartym wierszu widzimy hierarchiczny VQ-VAE. Piąty rząd to rezultaty działania podobnego kodera-dekodera Opus. Obraz autorstwa OpenAI

Dzięki wytrenowaniu na zbiorze danych zawierającym 1,2 miliona utworów Jukebox stanowi krok naprzód w dziedzinie generatywnego modelowania muzyki. Zachowując muzyczną spójność, zgodność z tradycyjnymi schematami charakterystycznymi dla rozmaitych pieśni, autentyczność partii solowych i replikacji ludzkiego głosu w generowanych utworach wykazuje wyraźny postęp względem wczesnych idei rekombinacji czy kompozycji algorytmicznej.

Kolejne przełomy w ewolucji sztucznej inteligencji w muzyce

Ciągły rozwój i zwiększająca się obecność sztucznej inteligencji w muzyce doprowadziły do tego, że technologia ta znalazła wiele zastosowań komercyjnych. Na przykład serwis LANDR wykorzystuje algorytmy głębokiego uczenia w procesie automatycznego masteringu nagrań. Ponadto w wielu przypadkach wykorzystano kombinacje sieci neuronowych i algorytmów uczenia przez wzmacnianie podczas tworzenia nagrań komercyjnych, takich jak album Taryn Southern (koprodukcja Amper Music) czy album Hello World (zrealizowany przy użyciu Flow Machines firmy Sony z udziałem różnych artystów). W miarę rozwoju tych algorytmów i sieci neuronowych już w niedalekiej przyszłości w mainstreamowych mediach będzie pojawiało się coraz więcej muzyki tworzonej przy wsparciu sztucznej inteligencji.

Od czasów pionierskich prac takich badaczy takich jak Hiller/Isaacson i Cope stopień wyrafinowania technologii sztucznej inteligencji wciąż rośnie, a jej upowszechnienie w przemyśle muzycznym gwałtownie przybiera na sile. Aplikacje komercyjne wspomagają dziś artystów w procesie twórczym, również w przypadku muzyki filmowej i tła, jednak rola ludzkiego umysłu na tym polu wciąż pozostaje niezachwiana, gdyż tylko on pozwala na zachowanie prawdziwej emocjonalności i twórczej głębi w muzyce.

Nie ulega wątpliwości, że wraz ze wzrostem dostępności i możliwości sztucznej inteligencji zmieni ona branżę muzyczną. Jednak zamiast bezradnie rozkładać ręce wobec tych nieuchronnych przemian, muzycy mogą uczyć się wykorzystywać ją jako kolejny krok we własnej ewolucji twórczej, odpowiednio dostosowując swój sposób pracy.