Tajemnice stereo

Te dwa monitory, które stoją na Twoim biurku lub konsolecie w studiu nagrań, mogą się okazać znacznie potężniejszym narzędziem do produkcji muzycznej niż do tej pory sądziłeś.

Te dwa monitory, które stoją na Twoim biurku lub konsolecie w studiu nagrań, mogą się okazać znacznie potężniejszym narzędziem do produkcji muzycznej niż do tej pory sądziłeś.

Wokół nas dzieje się bardzo wiele rzeczy, które są intensywnie analizowane przez nasz mózg. Choć wzrok przekazuje mnóstwo informacji, to oczy mogą być skierowane tylko w jedną stronę, można je zamknąć, a poza tym nie widzimy nic w ciemnościach. Na szczęście mamy parę tworów skórno-chrzęstnych śmiesznie odstających po bokach naszej głowy.

Nasz słuch, jak każdy inny zmysł, monitoruje informacje dochodzące do nas z otoczenia, przekazując je do mózgu, który przetwarza je na budowany w naszej świadomości obraz tego, co dzieje się wokoło. Bardzo istotnym składnikiem tych informacji jest to, że system słyszenia potrafi określić kierunek, z którego nadchodzi dźwięk, co jest niesłychanie ważne w sytuacji gdy biegnie w naszym kierunku dzikie zwierzę lub przechodzimy przez zatłoczone skrzyżowanie.

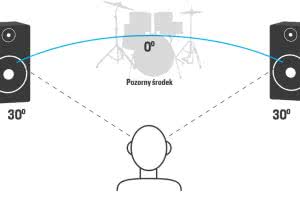

Owo określanie kierunku jest wyjątkowo precyzyjne. Z testów laboratoryjnych wynika, że w dobrych warunkach możemy zidentyfikować zmianę kąta położenia źródła dźwięku z dokładnością do 1 stopnia! Jeśli zatem zrozumiemy sposób, w jaki nasz mózg interpretuje dobiegające do nas sygnały akustyczne, wówczas możemy lepiej zapanować nad obrazem przestrzennym naszych utworów i stać się lepszymi producentami. Co ciekawe, nasz słuch jest tak precyzyjny głównie dzięki temu, że mamy dość duży, sferoidalny i (niekiedy) owłosiony obiekt między uszami: naszą głowę.

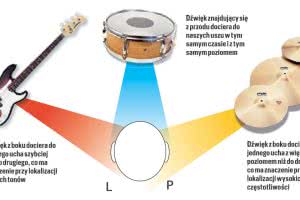

Pierwszym elementem, który pozwala na identyfikację lokalizacji źródła dźwięku jest różnica w poziomach sygnałów odbieranych przez nasze uszy. Jeśli źródło to znajduje się na lewo od nas, wówczas dźwięk dociera do ucha lewego bez żadnych problemów. Jednocześnie ten sam dźwięk dochodzi do prawego ucha wzdłuż obwodu głowy (efekt dyfrakcji), tracąc jednak część swojej energii. Tym samym będzie odbierany przez prawe ucho z mniejszym poziomem wynikającym z dodatkowo przebytej odległości oraz występowania „cienia akustycznego” pod postacią naszej głowy. Tę zmianę poziomów możemy zasymulować poprzez panoramowanie dźwięku: przekręcając kontrolkę lub gałkę Pan w lewą stronę sprawiamy, że sygnał w prawym kanale będzie cichszy.

Innym czynnikiem, na podstawie którego nasz mózg określa kierunek, z którego dobiega dźwięk, jest różnica czasowa wynikająca z odległości pomiędzy uszami. Dźwięk pochodzący z obiektów znajdujących się dokładnie na wprost nas dociera do obu uszu w tym samym momencie, ale gdy obiekt znajdzie się z lewej lub prawej strony, wówczas wytwarzany przez niego dźwięk dotrze do jednego ucha szybciej niż do drugiego. Choć opóźnienie to nie jest czymś, co jest przez nas świadomie identyfikowane, to jednak wystarczy do tego, by mózg je zdekodował i zamienił na konkretną informację przestrzenną.

Różnice w poziomach sygnału mają większe znaczenie w przypadku lokalizacji dźwięków o wyższej częstotliwości, podczas gdy różnice czasowe (fazowe) są istotniejsze przy niższych częstotliwościach.

Tak naprawdę jest dużo więcej czynników, które pozwalają nam zidentyfikować kierunek dochodzenia dźwięku z naszego otoczenia, ale w świecie produkcji muzycznej są one bardzo trudne do odwzorowania.

Pierwszy z nich jest oczywisty - możemy ruszać głową. Obracając ją w lewo, prawo, podnosząc do góry i opuszczając dostarczamy do mózgu więcej informacji o dźwięku, mogąc znaleźć optymalne miejsce, w którym różnica w czasach i poziomach będzie na tyle mała, by móc się skupić na istocie dźwięku. Nie wykorzystujemy jednak tego w trakcie słuchania muzyki, ponieważ na ogół dobiega ona z kilku źródeł.

Po drugie, jeśli przyjrzysz się budowie ucha to zauważysz, że dźwięk nie dociera bezpośrednio do ucha wewnętrznego, ale z udziałem odbicia od wewnętrznej strony małżowiny usznej. Fala dźwiękowa odbija się od pofalowanej powierzchni, co powoduje powstawanie różnego typu mikroopóźnień i przekłada się na charakterystykę dźwięku. Co ciekawe, jeśli umieściłbyś małe mikrofony wewnątrz swoich uszu (co jest możliwe, ponieważ funkcjonują mikrofony douszne HRTF/binauralne) i odtworzył pochodzący z nich sygnał na słuchawkach dousznych noszonych przez kogoś innego, to dźwięk, jaki on usłyszy, wcale nie będzie dla niego naturalny i przyjemny, lecz raczej dziwny i nieprzyjazny.

Wspomniano już o subtelnych różnicach w czasie pomiędzy sygnałem docierającym do naszych uszu, co przekłada się na rozpoznawanie jego kierunku. Mózg określa kierunek bazując na tym, które ucho przekaże mu jako pierwsze informację o dźwięku, a następnie jakie jest opóźnienie w dźwięku docierającym do ucha drugiego. Najdłuższy czas opóźnienia w odbiorze drugiego dźwięku zależy od kształtu naszej głowy, ale po uśrednieniu i w normalnych warunkach atmosferycznych wynosi on około 0,7 milisekundy.

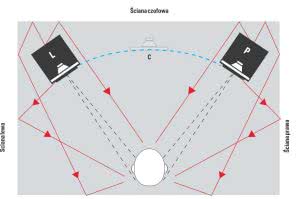

A jak to wygląda w przypadku pogłosu? Odbicia dźwięku, które są zmutowanymi kopiami sygnału oryginalnego, mogą do nas dotrzeć znacznie później niż dźwięk bezpośredni. W typowym pomieszczeniu powstaje mnóstwo odbić dźwięku dochodzących do słuchacza z różnych kierunków. Dlaczego zatem pogłos nie oszukuje naszego mózgu? Na to pytanie znalazł odpowiedź Helmut Haas.

Odkrył on, że nasz mózg do identyfikacji kierunku dochodzenia sygnału akustycznego używa tylko najszybciej docierających fal, a następnie „grupuje” wczesne odbicia, rozmywając je do postaci jednego, odczuwalnego dźwięku. Jak stwierdził Haas, każde odbicie, które dotrze do nas w ciągu 30 milisekund, będzie w ten sposób skumulowane, a odbicia późniejsze zostaną zdefiniowane jako echo, czyli wyraźne powtórki dźwięku.

Jak można tę wiedzę przenieść na grunt produkcji muzycznej? Przede wszystkim, jeśli powielimy pojedynczy kanał mono, oryginał ustawimy w lewym kanale, kopię w prawym, a następnie nieznacznie przesuniemy w czasie (opóźnimy) jeden z nich, słuchacz będzie cały czas słyszał jeden dźwięk, ale dobiegający z innego kierunku niż na wprost. Jeśli wprowadzone opóźnienie nie przekroczy 1 ms, można tę technikę stosować do klasycznego „panoramowania” dźwięku, ale przy większych opóźnieniach zaczyna się już pojawiać poczucie przestrzeni stereo. Czas opóźnienia można zwiększać do 30 ms, pamiętając o tym, że w tym okienku czasowym cały czas słyszymy jeden dźwięk, a nie dwa, przesunięte względem siebie w czasie.

Jeśli teraz zaczniemy modulować wielkość opóźnienia, to w sytuacji, gdy nie przekroczy ono 30 ms będziemy mieli do czynienia z efektem flanger, a powyżej 30 ms, gdy zjawisko Haasa już nie obowiązuje, będziemy słyszeć „zdublowany” dźwięk, znany też jako chorus. Owo niewielkie przesunięcie czasowe odgrywa też istotną rolę w stereofonicznych konfiguracjach mikrofonów (o czym na następnych stronach).

Jednym z potencjalnych problemów wynikających z zastosowania efektu Haasa jest kompatybilność z trybem mono. Kiedy sygnał bezpośredni i opóźniony zostają zsumowane, w efekcie powstaje zjawisko filtrowania grzebieniowego. Gdy sygnały o tych samych częstotliwościach pojawią się w tym samym momencie ale z przeciwną biegunowością, wówczas nastąpi wyciszenie dźwięku. Nie zawsze jest to problemem, a niekiedy można to zjawisko wykorzystać kreatywnie, niemniej przy stosowaniu takich zabiegów warto sprawdzać swoje miksy w odsłuchu monofonicznym, by upewnić się, że wszystko brzmi jak trzeba.